HARK FORUM › 連続してループ中のループを実行する問題 › Reply To: 連続してループ中のループを実行する問題

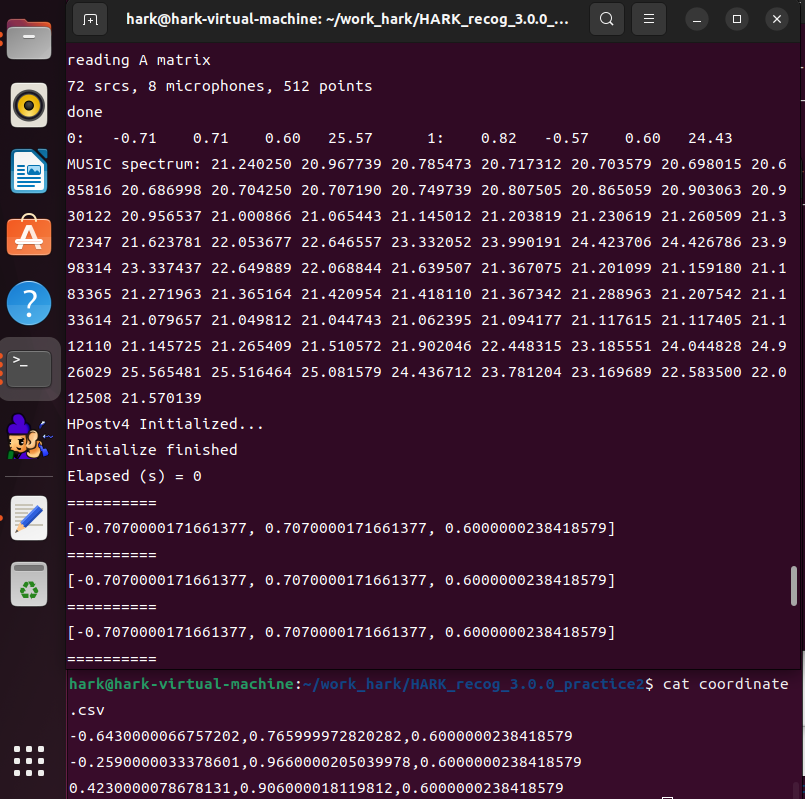

頂いたノード (定位結果を CSV ファイルに出力する Python ノード) の実装を用いて Ubuntu がインストールされた VM 上で動作の確認をさせて頂きました。

結果が得られないという状況が再現できず、定位結果が正常に CSV ファイルに保存されていましたので下記についてご確認ください。

1. “all” などの出力端子が MAIN (LOOP を置いている subnet) でも出力端子が設定されていること。

これが行われないとノードが実行対象から除外されている可能性があります。

2. DisplayLocalization ノードの代わりに SaveSourceLocation ノードなどでファイル出力を行う。

XML 形式で読みづらい出力ファイルとなってしまいますが、ファイルは確実に出力されますので定位が出ているか否かの確認が出来ます。Python ノードに起因する部分を無視できますので、ここで定位結果が得られない場合は定位が出来ていない可能性が御座います。

3.CSV ファイルの出力先のアクセス権をご確認ください。

書き込み禁止の場所で実行しますとファイルが生成されない事が御座います。

4.下記のサンプルで結果が得られることをご確認ください。

下記の URL に我々が提供しているサンプルが御座います。

https://hark.jp/download/samples/

下記のサンプルファイルをダウンロードして頂き、

https://hark.jp/networks/HARK_recog_3.0.0_practice2.zip

本投稿に添付している patch.7z の内容を上記サンプルのディレクトリ内に展開します。

export OPENBLAS_NUM_THREADS=1 && ./sep_rec_offline_loop_wo_disp_write_csv.n

のように実行して頂くと、処理が行われ 999.py の結果が output.png にあるような内容で出力されます。

最初の環境変数設定はコア数の多いPCで処理速度が落ちないようにするために設定していますが、無くても実行は可能です。

5.以上の対処で解決が出来ない場合は、実行環境の HARK を最新版に更新することをご検討ください。HARK 講習会などで使用している既に HARK がインストール済みの VM イメージを一般公開しております。下記の URL の「第22回HARK講習会用のファイル一式の URL」から VM イメージを取得する事が可能です。

https://www.hark.jp/document/tutorial/2023/practice0.html

———-

DisplayLocalization を接続すると Python が応答なしとなる件について:

原因は Python の GIL に起因するもので複数の Python ノードを使用している場合に UI を描画するノードを使用すると処理が重い場合に応答なしのダイアログが表示されるという状況が発生していることが分かりました。ダイアログを「キャンセル」で閉じると処理が継続されますが、頻繁に停止してしまうことから描画系のノードは使用を控えてファイル出力などでご対応頂けないでしょうか。

PyHARK では各ノードをマルチスレッド・マルチプロセスで処理を行っておりますので PyHARK に移行して頂くことでも回避が可能です。

もし PyHARK にご興味が御座いましたら、下記 HARK 講習会の資料でも紹介しております。 practice3 が PyHARK の紹介となっております。

https://www.hark.jp/document/tutorial/2023/practice0.html

https://www.hark.jp/document/tutorial/2023/practice1.html

https://www.hark.jp/document/tutorial/2023/practice2.html

https://www.hark.jp/document/tutorial/2023/practice3.html

以上、宜しくお願い致します。

HARK Support Team.

-

This reply was modified 1 year, 11 months ago by

Masayuki Takigahira.

-

This reply was modified 1 year, 11 months ago by

Masayuki Takigahira.

-

This reply was modified 1 year, 11 months ago by

Masayuki Takigahira.